Googles Suchmaschine entwickelt sich weiter zur dialogfähigen Wissensquelle. Mit dem AI Mode ergänzt der Konzern die bereits in Deutschland verfügbaren AI Overviews um eine tiefgreifendere, kontextorientierte Funktion – bislang allerdings nur für Nutzer in den USA, die über Google Labs Zugang haben. Nun kündigt Google ein Update an, das vor allem durch bessere Multimodalität und optimiertes Reasoning überzeugen soll.

Detaillierte Antworten durch strukturierte Suchverarbeitung

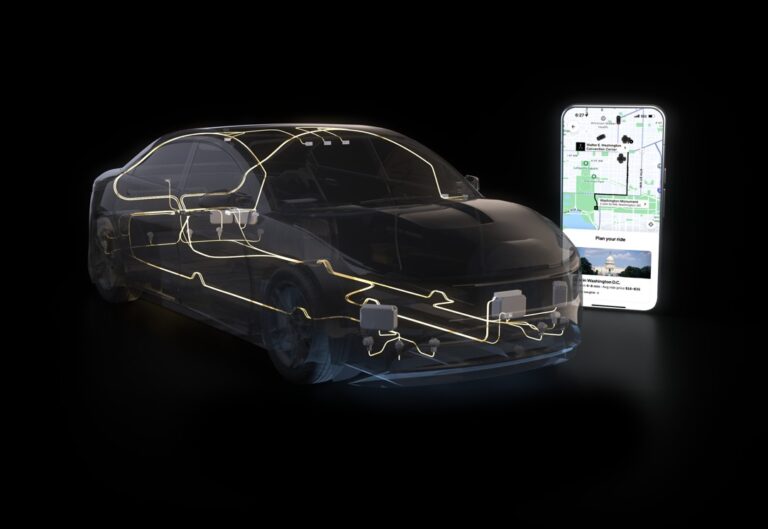

Der AI Mode ist Googles Antwort auf komplexere Suchbedürfnisse. Statt wie bisher nur Kurzantworten zu liefern, analysiert die KI differenzierte Fragen, unterteilt sie in Teilaspekte und liefert strukturierte, zusammenhängende Informationen. Dabei kombiniert Google Daten aus dem Web, seinem Knowledge Graph sowie Shopping- und Echtzeitdaten.

Diese Antworten gehen deutlich über die AI Overviews hinaus. Sie zeigen nicht nur direkte Fakten, sondern ermöglichen auch argumentative Vergleiche und Verweise auf relevante Inhalte. Unterstützt wird das Ganze durch eine angepasste Version des Sprachmodells Gemini 2.0.

Gewinnen in der Plattform-Ökonomie

Multimodale Suchen jetzt möglich

Ein zentrales Feature des Updates ist die neue multimodale Fähigkeit: Nutzer können ein Bild aufnehmen oder hochladen und eine darauf bezogene Frage stellen. Die Antwort kombiniert visuelle Analyse mit Textverständnis – gestützt auf Googles Lens-Technologie und Gemini. Damit wird das Motto „Search what you see“ Realität und erschließt eine neue Form der Interaktion mit Suchinhalten.

Shortcut zum AI Mode und experimenteller Zugang

In den USA ist nun auch ein Shortcut zum AI Mode in der Google-App verfügbar. Ein Symbol mit Lupe und Stern weist auf den Zugriff hin. Der AI Mode bleibt vorerst ein Experiment innerhalb der Google Labs. Ob er langfristig mit den AI Overviews verschmilzt oder separat weitergeführt wird, ist offen.